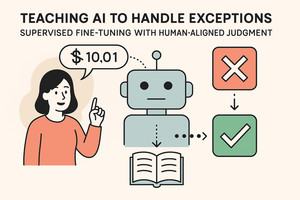

AI의 융통성 강화: 인간의 '예외적 사고방식' 학습으로 LLM의 실세계 의사결정 능력 향상

🤖 AI 추천

AI 및 머신러닝 엔지니어, 데이터 과학자, AI 연구원, 그리고 AI 에이전트의 실세계 적용 범위를 확장하고자 하는 개발자들에게 추천합니다. 특히 LLM의 한계를 극복하고 더욱 인간적인 판단 능력을 갖춘 AI 모델 개발에 관심 있는 모든 IT 전문가에게 유익한 정보가 될 것입니다.

🔖 주요 키워드

- 핵심 기술: 대규모 언어 모델(LLM)이 실세계 의사결정 에이전트로 발전함에 따라 발생하는 융통성 부족 문제를 해결하기 위해, 인간의 '예외적 사고방식'과 의사결정 이유를 학습시키는 새로운 접근 방식이 제시되었습니다.

- 기술적 세부사항:

- 문제점: LLM은 규칙에 대한 엄격한 준수 경향으로 인해 맥락을 파악하지 못하고 비효율적인 의사결정을 내리는 경우가 있습니다 (예: 1센트 초과로 인해 밀가루 구매 포기).

- 해결 방안: 인간의 예외적 사고방식과 판단 이유를 포함한 설명을 지도 미세조정(SFT)하는 것이 효과적입니다.

- 실험 방법: 윤리적 프레임워크 프롬프팅, 사고 사슬(CoT) 추론, 지도 미세조정(SFT) 등의 방법을 비교 실험했습니다.

- 실험 결과: SFT를 통해 인간의 판단에 맞춘 LLM은 새로운 시나리오에서도 인간과 유사한 결정을 내릴 확률이 70% 이상으로 향상되었습니다.

- 핵심 요소: 최소 50개 이상의 인간 예외적 사고방식 및 판단 이유 학습이 중요하며, '예/아니오' 결과뿐 아니라 설명까지 포함해야 합니다.

- 개발 임팩트: LLM이 더욱 인간적이고 융통성 있는 의사결정을 내릴 수 있게 되어, 고객 서비스, 의료 등 다양한 산업 분야에서 AI의 신뢰성과 활용성을 크게 높일 수 있습니다. 이는 AI 에이전트의 실세계 적용 범위를 확장하는 데 중요한 기여를 할 것입니다.

- 커뮤니티 반응: (본문에서 직접적인 커뮤니티 반응은 언급되지 않았으나, 논문 게재는 학계 및 연구 커뮤니티의 관심을 끌 것으로 예상됩니다.)

- 톤앤매너: 이 기술은 LLM이 단순한 패턴 인식을 넘어 복잡한 인간의 판단 과정을 이해하고 모방하도록 훈련하는 데 초점을 맞추고 있습니다. 이는 AI의 '정렬(Alignment)' 문제를 해결하기 위한 중요한 진전으로 볼 수 있습니다.

📚 관련 자료

Hugging Face Transformers

다양한 LLM 모델의 구현 및 미세조정(SFT 포함)을 위한 필수 라이브러리를 제공하며, 본문에서 언급된 GPT, Llama 등 모델에 대한 연구 및 개발에 직접적으로 활용될 수 있습니다.

관련도: 95%

OpenAI Gym

AI 에이전트의 강화학습 및 환경 상호작용에 대한 연구를 위한 표준 API를 제공합니다. LLM을 의사결정 에이전트로 활용하는 맥락에서, 예외 처리 학습을 위한 환경을 구축하는 데 간접적으로 관련될 수 있습니다.

관련도: 70%

LangChain

LLM을 활용한 애플리케이션 개발을 위한 프레임워크로, 복잡한 의사결정 체인을 구성하고 외부 데이터와 통합하는 데 사용됩니다. 인간의 의사결정 방식을 모방하는 LLM 에이전트 개발에 유용하게 활용될 수 있습니다.

관련도: 85%