LLM의 한계를 극복하는 '작지만 똑똑한 모델': TRM 논문 분석

🤖 AI 추천

LLM의 효율성 및 신뢰성 문제를 해결하고, 작고 효율적인 AI 모델 개발에 관심 있는 AI 연구원, 머신러닝 엔지니어, 그리고 최신 AI 기술 동향을 파악하고자 하는 개발자들에게 본 콘텐츠를 추천합니다.

🔖 주요 키워드

핵심 기술

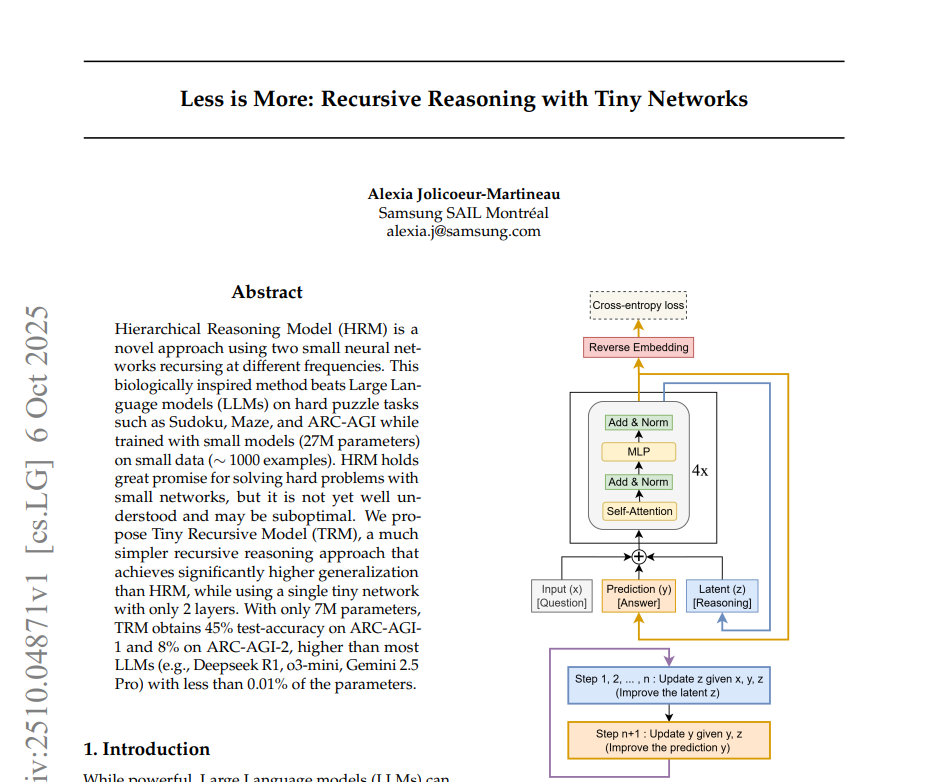

최근 LLM의 막대한 자원 소모와 효율성 문제를 극복하기 위해, "작지만 똑똑한 모델(small but smart)" 개발의 중요성이 대두되고 있습니다. 본 콘텐츠는 삼성전자 북미 AI 연구소의 최신 연구 "Less is More: Recursive Reasoning with Tiny Networks"를 분석하여, 기존 LLM의 한계를 넘어서는 Tiny Recursive Model (TRM)의 혁신적인 접근 방식을 소개합니다.

기술적 세부사항

- LLM의 한계: 수조 개의 파라미터를 가진 모델도 고차원 추론 벤치마크(ARC-AGI)에서 인간 수준의 일반화 능력에 도달하지 못했으며, 자동회귀 방식의 출력 생성으로 인한 전체 답변 무효화 위험 및 신뢰성 문제가 존재합니다.

- 기존 솔루션 및 한계: Chain-of-Thought (CoT)와 Test-Time Compute (TTC)는 정확도 및 신뢰성 향상에 기여하지만, 고품질 추론 데이터 요구, 오답 강화 가능성, 계산량 증가 등의 한계가 있습니다.

- Hierarchical Reasoning Model (HRM)의 제안: 복잡한 퍼즐형 문제 해결에서 획기적 성능을 보였으나, 수학적 근거 부족, 학습 비효율성, 불필요한 복잡성 등의 근본적인 한계가 있었습니다.

- HRM의 특징: Recursive Hierarchical Reasoning (저주파/고주파 네트워크 교차 활용) 및 Deep Supervision (점진적 답 개선) 기법을 사용했습니다.

- HRM의 한계: 재귀적 계층 구조보다는 Deep Supervision의 영향이 더 컸으며, 특히 고정점 수렴 가정 및 Adaptive Computational Time (ACT)의 비효율성이 지적되었습니다.

- Tiny Recursive Model (TRM)의 제안: HRM의 한계를 극복하는 새로운 접근 방식으로, '답을 스스로 고쳐 나가는 작은 네트워크'라는 점에서 효율성을 극대화했습니다.

- TRM의 기본 구조: 입력, 예측 답, 내부 상태를 함께 처리하고, 내부 상태를 n번 반복 업데이트 후 답을 개선하는 과정을 여러 Supervision step 반복.

- TRM의 주요 개선점:

- 고정점 이론 제거 및 안정적인 역전파 학습

- 단일 네트워크 구조로 파라미터 절반 감소 및 일반화 성능 향상

- 2개의 층이 최적 구조임을 확인 (작은 모델의 일반화 강점)

- 자기회귀(Self-Attention) 제거 가능 (MLP의 효율성)

- ACT 단순화 (계산량 절반 감소)

- EMA (지수이동평균)를 통한 안정적 학습 및 높은 정확도

개발 임팩트

TRM은 ARC-AGI 벤치마크에서 거대한 LLM 대비 10분의 1 수준의 데이터와 0.01% 미만의 매개변수 크기로 추론 능력을 뛰어넘었습니다. 이는 AI 모델 개발의 패러다임을 '크기'에서 '효율성과 지능'으로 전환할 수 있는 잠재력을 보여주며, 자원 제약이 있는 환경에서의 AI 활용 가능성을 크게 확장시킬 것으로 기대됩니다.

커뮤니티 반응

(본문에서 직접적인 커뮤니티 반응 언급은 없습니다.)

📚 관련 자료

transformers

Hugging Face의 Transformers 라이브러리는 다양한 LLM 및 NLP 모델의 구현과 학습을 지원합니다. TRM과 같은 효율적인 모델 연구는 Transformers 생태계 내에서 더 작고 효율적인 모델 아키텍처 연구에 영감을 줄 수 있습니다.

관련도: 85%

PyTorch

PyTorch는 딥러닝 모델 개발을 위한 주요 프레임워크입니다. TRM 논문에서 제안된 재귀적 추론, 심층 감독, 단일 네트워크 구조 등의 기법 구현은 PyTorch와 같은 프레임워크를 통해 이루어질 것입니다. 효율적인 모델 학습 및 실험에 필수적입니다.

관련도: 90%

ARC-AGI

Abstraction and Reasoning Corpus (ARC)는 논문에서 언급된 고차원 추론 벤치마크입니다. TRM과 같은 연구는 ARC 데이터셋을 사용하여 모델의 추론 능력과 일반화 성능을 평가하고 개선하는 데 중점을 둡니다. 이 저장소는 벤치마크 자체에 대한 정보를 제공합니다.

관련도: 95%