LLM 학습의 새로운 지평: ICL과 미세조정의 장점을 결합한 '증강 미세조정' 방법론

🤖 AI 추천

LLM의 일반화 성능 향상과 효율적인 학습 방식에 관심 있는 AI 연구원, 머신러닝 엔지니어, 자연어 처리(NLP) 개발자에게 이 콘텐츠를 추천합니다.

🔖 주요 키워드

핵심 기술

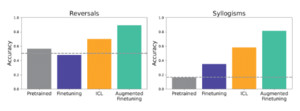

구글 딥마인드와 스탠포드대 연구진이 LLM의 일반화 성능을 높이기 위해 '상황 내 학습(ICL)'과 '미세조정(fine-tuning)'의 장점을 결합한 새로운 '증강 미세조정(Augmented Fine-Tuning)' 학습법을 제안했습니다. ICL이 미세조정보다 뛰어난 일반화 성능을 보였으나 추론 비용이 높다는 단점을 해결하려는 시도입니다.

기술적 세부사항

- 미세조정 (Fine-tuning): 사전 학습된 LLM의 내부 매개변수를 소규모 데이터셋으로 재학습시키는 방식입니다.

- 상황 내 학습 (In-Context Learning, ICL): 모델의 매개변수를 변경하지 않고, 문제와 함께 예제를 포함한 프롬프트를 제공하여 학습을 유도하는 방식입니다. 사용이 용이하나 추론 시 높은 계산 비용이 발생합니다.

- 연구 결과: 통제된 인공 데이터셋(가상 가족관계, 허구 개념 계층 구조 등)을 이용한 비교 분석 결과, ICL이 관계 역전, 삼단 논법 등에서 더 뛰어난 일반화 성능을 보였습니다.

- 증강 미세조정 (Augmented Fine-Tuning): LLM의 ICL 능력을 활용하여 새로운 예제를 생성하고, 이를 미세조정 학습 데이터로 사용하는 방식입니다.

- 로컬 전략: 개별 문장 변형, 단일 정보로부터 역추론 등 직관적인 추론 결과 생성.

- 글로벌 전략: 전체 데이터셋을 문맥으로 제공하여 더 깊은 추론 유도.

- 효과: ICL의 반복 수행 없이 모델의 안정성과 유연성을 높이며, 장기적으로 ICL보다 총 비용이 낮을 수 있습니다.

개발 임팩트

증강 미세조정은 ICL의 높은 일반화 성능과 미세조정의 효율성을 결합하여 LLM의 실용성을 크게 향상시킬 수 있습니다. 특히, 데이터 증강을 통해 모델이 새로운 과제에 더 잘 적응하도록 만들어 향후 파운데이션 모델 학습 및 일반화 능력 이해에 기여할 것으로 기대됩니다. 미세조정만으로 성능이 부족할 때 대안으로 고려될 수 있습니다.

커뮤니티 반응

본문에서 직접적인 커뮤니티 반응은 언급되지 않았으나, ICL과 미세조정 방식의 비교 및 새로운 학습법 제시는 LLM 연구 및 개발 커뮤니티에서 큰 관심을 받을 것으로 예상됩니다.

📚 관련 자료

transformers

Hugging Face의 transformers 라이브러리는 다양한 LLM 모델의 로딩, 미세조정 및 ICL 구현을 위한 필수적인 도구들을 제공합니다. ICL 기반 프롬프트 엔지니어링 및 미세조정 예제를 실습하는 데 직접적으로 활용될 수 있습니다.

관련도: 95%

LLaMA

Meta AI에서 공개한 LLAMA 모델은 ICL 및 미세조정 연구의 기반이 되는 강력한 언어 모델 중 하나입니다. 연구에서 사용된 'Gemini 1.5 Flash'와 유사한 역할을 하며, 이 코드를 통해 모델의 일반화 성능을 직접 테스트하고 비교할 수 있습니다.

관련도: 90%

trl

trl (Transformer Reinforcement Learning) 라이브러리는 RLHF(Reinforcement Learning from Human Feedback)와 같은 고급 학습 기법을 지원하며, ICL을 활용한 데이터 증강이나 이를 활용한 미세조정 과정에서 필요한 학습 파이프라인 구축에 유용하게 사용될 수 있습니다.

관련도: 85%