로컬 AI 혁명: Qwen3 모델을 LM Studio로 쉽게 실행하고 개발 효율 높이기

🤖 AI 추천

로컬 환경에서 최신 대규모 언어 모델(LLM)을 활용하여 개발 생산성을 높이고자 하는 개발자, AI 연구자 및 기술 애호가.

🔖 주요 키워드

핵심 기술

최근 주목받는 대규모 언어 모델(LLM)인 Qwen3를 로컬 PC 환경에서 LM Studio를 사용하여 손쉽게 실행하고 활용하는 방법을 소개합니다. 이는 프라이버시 보호, 비용 효율성, 오프라인 사용성을 동시에 제공합니다.

기술적 세부사항

- Qwen3 모델 소개: 제3세대 LLM으로, 특히 코딩, 수학, 추론 태스크에서 뛰어난 성능을 보입니다.

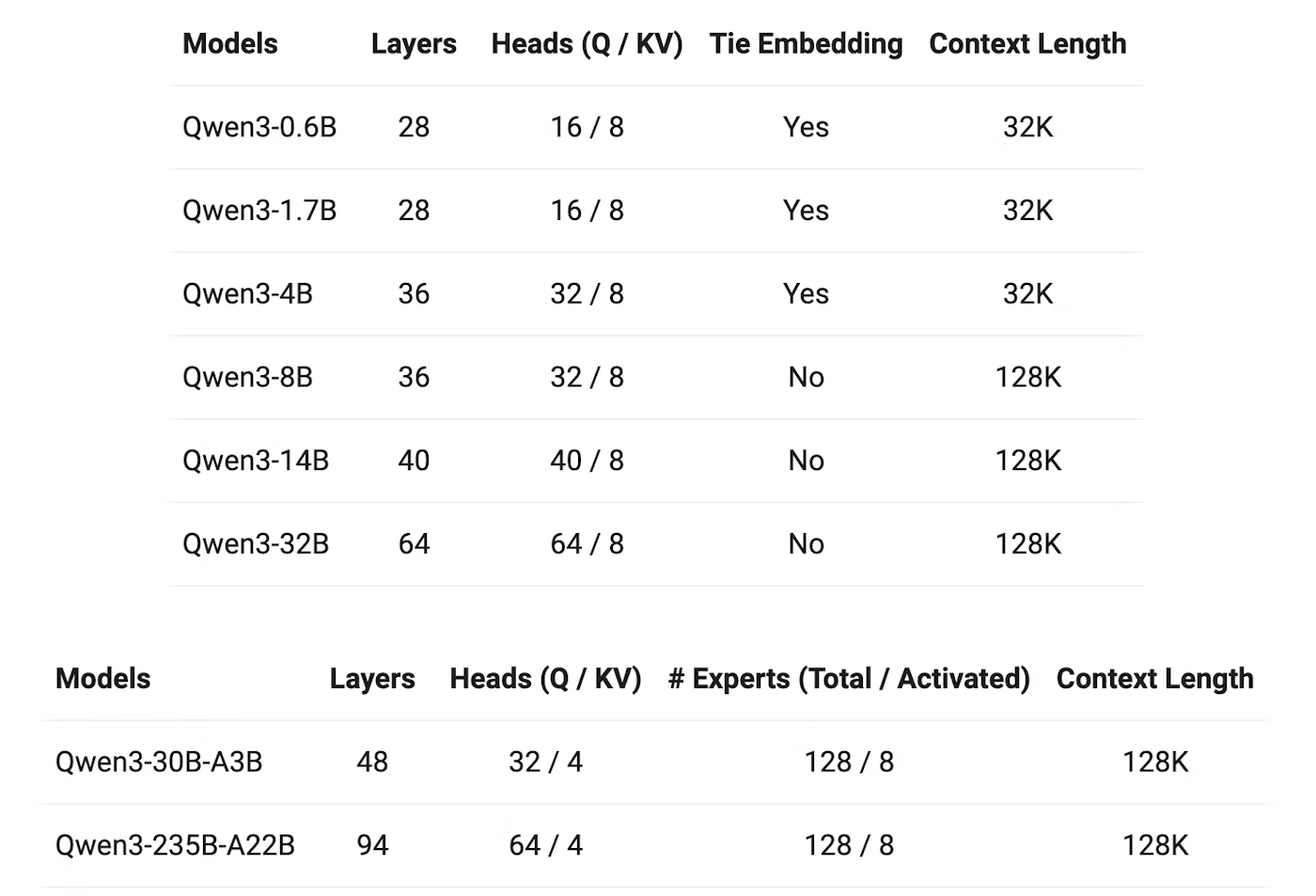

- 다양한 크기의 모델 제공: 밀집 모델(Qwen3-32B, 14B, 8B, 4B, 1.7B, 0.6B) 및 MoE 모델(Qwen3-235B-A22B, Qwen3-30B-A3B).

- Apache 2.0 라이선스로 오픈소스화.

- 주요 특징:

- 사고 모드 전환: 복잡한 추론을 위한 '사고 모드'와 즉각적인 답변을 위한 '비사고 모드'.

- 다국어 지원: 119개 언어 및 방언 지원 (한국어 포함).

- 에이전트 기능 강화: 향상된 코드 생성 능력.

- 트레이닝 방법 진화: 약 36조 토큰 학습, 4단계 트레이닝 파이프라인.

- 성능: 작은 모델(예: Qwen3-1.7B, 4B)이 이전 세대의 큰 모델과 동등하거나 우수한 성능을 발휘.

- LM Studio 활용: LLM을 로컬에서 쉽게 실행, 관리, 실행할 수 있는 도구.

- 커맨드라인 인터페이스(CLI) 제공 (

lms명령). - API 서버 실행 및 연동 지원.

- 모델 다운로드 및 실행 방법 (

lms get,lms server start). - cURL 및 Python, TypeScript 예제를 통한 API 연동 가이드.

- 커맨드라인 인터페이스(CLI) 제공 (

- Apidog 연동: 로컬 LM Studio API 테스트 및 디버깅을 위한 편리한 도구로 소개.

- API 요청 생성, 엔드포인트 설정, 응답 모니터링, JSONPath 추출 기능.

- 스트리밍 응답 테스트 용이성 강조.

개발 임팩트

- 로컬 환경에서 강력한 LLM을 활용하여 개발 생산성 향상.

- 프라이버시 걱정 없이 민감한 코드나 데이터를 처리 가능.

- 클라우드 API 비용 절감 및 오프라인 환경에서의 유연한 AI 활용.

- 작은 모델로도 높은 성능을 달성하여 하드웨어 제약 완화 및 접근성 증대.

커뮤니티 반응

글쓴이는 Qwen3-4B 모델의 성능과 일반 PC에서의 원활한 작동에 만족감을 표현하며, 커뮤니티에 자신의 경험을 공유하고 다른 사용자들의 사용 사례에 대한 논의를 제안하고 있습니다. (댓글 참여 독려)

톤앤매너

IT 개발 기술 및 프로그래밍 전문가를 대상으로, Qwen3 모델의 기술적 특징과 LM Studio를 활용한 실용적인 로컬 AI 구축 및 활용 방안을 전문적이고 명확하게 전달합니다.

📚 관련 자료

Qwen

Qwen3 모델을 개발한 팀의 공식 GitHub 저장소로, 모델 아키텍처, 학습 데이터, 성능 평가 등 핵심 기술 정보와 구현을 제공합니다.

관련도: 98%

LM Studio

콘텐츠에서 핵심적으로 다루는 로컬 LLM 실행 및 관리 도구인 LM Studio의 공식 웹사이트 및 관련 커뮤니티 허브입니다. CLI 도구 및 API 서버 기능을 제공합니다.

관련도: 95%

Apidog

콘텐츠에서 LM Studio API 테스트 및 디버깅 도구로 추천된 Apidog의 공식 저장소 또는 관련 정보 페이지입니다. 로컬 API와의 연동 편의성을 강조합니다.

관련도: 70%