50일간의 작은 언어 모델 개발 프로젝트

카테고리

프로그래밍/소프트웨어 개발

서브카테고리

인공지능, 머신러닝

대상자

- AI/머신러닝 개발자 및 중급 이상의 프로그래밍 경험자

- GPU 자원이 제한적인 환경에서 모델 개발을 원하는 사람들

- Transformer 아키텍처와 언어 모델 학습 메커니즘에 대한 근본적인 이해를 원하는 사람들

핵심 요약

- 작은 언어 모델(30M/15M 파라미터) 개발을 통해 GPU가 아닌 CPU 기반의 낮은 자원 환경에서도 모델 훈련이 가능함

- 자체 구현을 통해 Transformer의 핵심 구성 요소(의미적 인코딩, 레이어 정규화, 어텐션 계산)의 동작 원리를 직접 이해 가능

- 실제 개발 과정을 통해 디버깅 기술과 CLI 도구 개발(IdeaWeaver)이 도출됨

섹션별 세부 요약

1. 프로젝트 개요

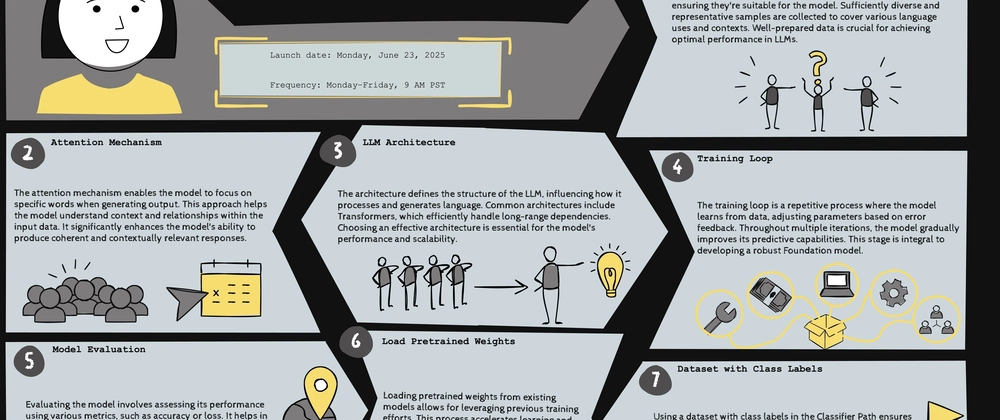

- 50일간의 시리즈로, 토큰화부터 배포까지의 전체 개발 과정 공유

- Tiny-Children-Stories-30M 및 DeepSeek-Children-Stories-15M 두 모델의 실험 결과를 기반으로 함

- GitHub 링크 및 문서 링크 제공

2. 작은 모델 선택 이유

- 접근성: GPU 대신 CPU 기반의 중간 성능 노트북이나 소규모 클라우드 GPU에서도 훈련 가능

- 속도: 파라미터 수를 30M 이하로 제한하여 일일 훈련 반복 가능

- 명확성: 자체 구현을 통해 어텐션 가중치 계산, 그래디언트 흐름, 불균형 요소를 직접 파악 가능

3. 자체 구현의 이점

- 개념 고착화: 이론적 지식(예: self-attention, tokenization)을 코드 구현으로 전환하여 직접 이해

- 디버깅 기술 향상: 모델 출력 오류 시 임베딩 룩업, softmax 정규화, 최적화기의 모멘텀 업데이트 등 핵심 단계 추적 가능

- 도구 개발: Python 스크립트와 구성 파일이 IdeaWeaver CLI(GenAI 워크플로우 통합 툴)의 기반으로 활용됨

4. 시리즈 로드맵

- 50일간의 글을 통해 데이터셋 수집, 훈련, 평가, RAG 파이프라인 등 주요 마일스톤 제공

- 각 게시물에 코드 스크립트, 다이어그램, 성능 차트 포함

5. 참여 방법

- 2025년 6월 23일부터 PST 기준 오전 9시 시작

- LinkedIn, Twitter/X, Medium, dev.to, Reddit 등 플랫폼에서 게시물 실시간 제공

- 댓글을 통해 질문 또는 주제 제안 가능

결론

- 작은 모델 개발을 통해 Transformer 핵심 메커니즘과 실무 개발 과정을 직접 학습할 수 있음

- IdeaWeaver CLI 도구를 통해 GenAI 워크플로우 자동화 가능

- 50일간의 시리즈를 통해 자체 구현 기술과 디버깅 능력 향상에 기여함