"AI 에이전트는 융통성이 필요해"...MIT, LLM '예외적 사고' 강화법 공개

카테고리

데이터 과학/AI

서브카테고리

인공지능, 머신러닝

대상자

AI 연구자, LLM 개발자, 에이전트 AI 설계자

- 난이도: 중급 이상 (LLM 아키텍처 및 학습 전략 이해 필요)

핵심 요약

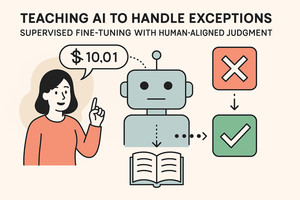

- LLM의 예외 처리 능력 강화는 인간의 사고 과정과 판단 근거를 학습해야 한다.

- 지도 미세조정(SFT)을 통해 50개 이상의 예외 사례와 설명을 학습하면 인간과 유사한 의사결정 가능.

- 윤리적 프레임워크 프롬프팅은 효과적이지 않으며, 사고 사슬(CoT) 추론은 부분적 개선만 유도.

섹션별 세부 요약

1. 문제 정의: LLM의 유연성 부족

- 예시: "10달러 제한 내 밀가루 구매" 요청 시, LLM은 1센트 초과 시 구매 거부하지만 인간은 맥락에 따라 유연하게 판단.

- 실험 결과: 92%의 인간 참가자가 예외적 사고를 적용해 구매 결정.

- 산업적 영향: AI 상담사의 무유연한 판단은 신뢰도 하락 및 의료 분야의 심각한 오류 가능성.

2. 해결 방안: 3가지 접근법 테스트

- 윤리적 프레임워크 프롬프팅: 인간 판단에 맞춘 명령어 제공 → 효과 없음.

- 사고 사슬(CoT) 추론: 사고 과정 서술 유도 → 부분적 개선.

- 지도 미세조정(SFT): 인간의 50개 이상의 예외 사례 + 설명 학습 → 70% 이상의 유연한 의사결정 가능성.

3. 실험 결과 및 모델 분석

- 테스트 모델: GPT-o1, GPT-4o, Llama 3.2 등.

- SFT 효과: 예외 사례의 상세한 설명이 학습에 중요.

- 결론: SFT가 인간 중심 의사결정 전이 학습을 가능하게 함.

결론

- LLM의 유연성 강화를 위해 인간의 예외적 사고와 판단 근거를 포함한 SFT가 필수적.

- 예시: "1센트 초과 밀가루 구매" 시, SFT 적용 후 70% 이상의 유연한 결정 가능.

- 핵심 팁: 예외 사례의 설명을 포함한 데이터셋을 사용해 SFT 수행.