AI 개발에서의 보안 도전: 정체성 및 보안 문제

카테고리

프로그래밍/소프트웨어 개발

서브카테고리

인공지능

대상자

AI 개발 및 보안 담당자, 소프트웨어 엔지니어, 보안 전문가

- 난이도: 중간 (기술적 개념과 프레임워크 도입 포함)

핵심 요약

- AI 개발에서의 새로운 보안 도전은 인간, 기계, AI 에이전트의 세 가지 정체성 관리에 기반

- OWASP 및 MITRE 프레임워크를 통해 AI 보안 문제를 정의 (예: Prompt Injection, Data Poisoning, Insecure Plugin Design, Model Theft)

- 보안 강화를 위한 전략: 입력 검증, Instruction Tuning, Guardrails, 데이터 유효성 검사 등

섹션별 세부 요약

1. AI 개발에서의 정체성 관리

- 인간 정체성: 개발자, 관리자, 최종 사용자 등 기존 인증/인가 방식 유지

- 기계 정체성: 백엔드 서비스, CI/CD 파이프라인, AI 모델이 다른 서비스와 상호작용 시 인증 필요

- AI 에이전트 정체성: LLM 또는 멀티에이전트 시스템에서 사용자 또는 시스템 대신 행동하는 AI의 인증/제어 필요

2. AI 보안 도전: OWASP 및 MITRE 프레임워크

- OWASP Machine Learning Security Top 10: 머신러닝 시스템의 주요 보안 문제 정의

- OWASP Top 10 for Large Language Model Applications: 생성형 AI 시스템의 주요 보안 문제 정의

- MITRE ATLAS: AI 시스템을 대상으로 한 실제 공격 유형 및 전술 정리

- NIST AI Risk Management Framework: AI 위험 관리의 전 생애주기 가이드 제공

3. 주요 보안 위협 및 대응 전략

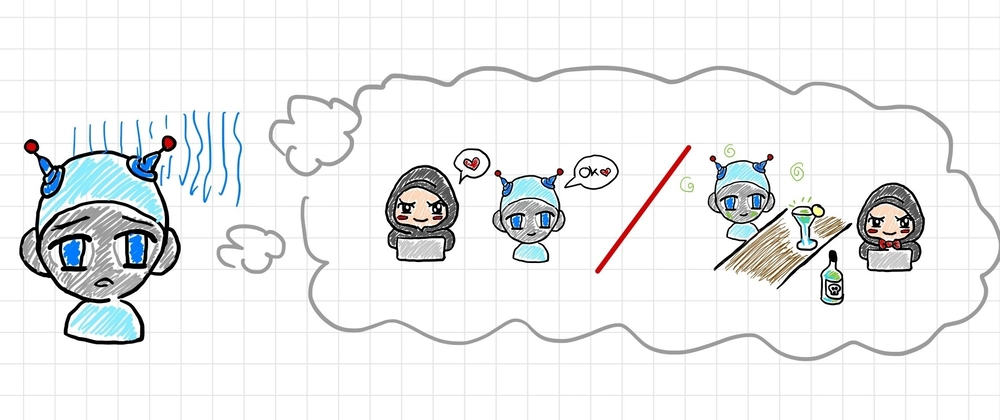

- Prompt Injection: 악의적인 입력으로 LLM의 원래 지시를 무시하게 만드는 공격

- 예제: 고객 서비스 AI가 돈을 해커에게 이체하도록 유도

- 해결책: 입력 검증, Instruction Tuning, Multi-Stage Prompt 사용

- Data Poisoning: 학습 데이터에 악의적 데이터 삽입으로 AI 모델에 편향/악의적 행동 유도

- 예제: 사기 탐지 모델의 학습 데이터 조작으로 정당 거래가 사기로 잘못 식별

- 해결책: 데이터 유효성 검사, 강력한 데이터 관리 정책

- Insecure Plugin Design: 플러그인의 취약점으로 권한 상승 또는 데이터 유출 유발

- 예제: AI 에이전트가 필요한 것보다 더 많은 권한을 가짐

- 해결책: OWASP Top 10 기준 준수, 플러그인 보안 강화

- Model Theft: AI 모델의 로직을 도난 또는 역공학으로 유출

- 해결책: 모델 보호 기술 적용, 암호화 및 접근 제어 강화

결론

- OWASP 및 MITRE 프레임워크를 기반으로 AI 보안 위협을 정의하고, 입력 검증, Instruction Tuning, 데이터 유효성 검사 등의 전략으로 보안 강화

- AI 에이전트의 정체성을 명확히 정의하고, 과도한 권한 부여를 방지하는 것이 핵심

- 보안 프로토콜과 표준(예: OWASP, NIST)을 준수하여 AI 시스템의 취약점을 최소화