AI 진실 조작: 정부가 현실을 어떻게 형성하는가

카테고리

트렌드

서브카테고리

인공지능

대상자

- AI 윤리, 정책 결정자, 기술 전문가

- 난이도: 중간 (AI의 사회적 영향 이해가 필요)

핵심 요약

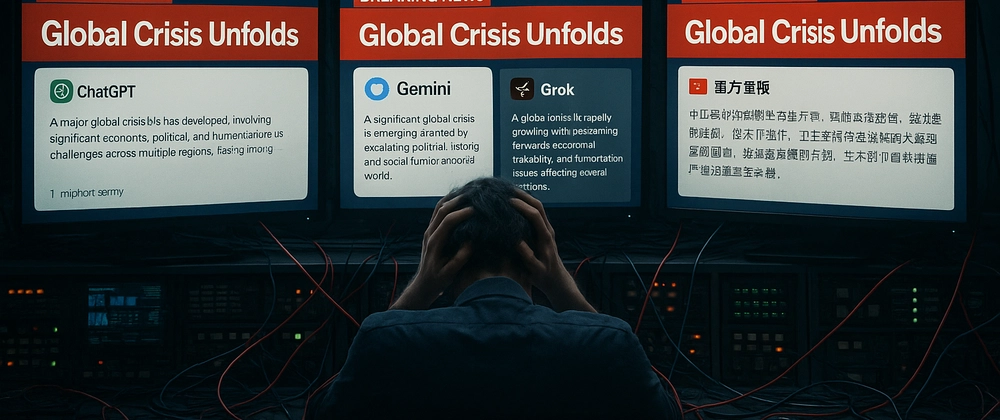

- AI를 통해 정부가 "진실"을 조작하는 방식은 narrative engineering으로, 반복을 통한 정상화**가 핵심

- 중국, 러시아, 서방 국가는 각각 경직된 검열, 혼란 유도, 중립성 vs 조작성 갈등을 표방

- AI 사용자에게 권장사항: 모델 출처 파악, 다중 시스템으로 결과 검증, AI의 인지 수준 분석

섹션별 세부 요약

1. AI가 진실을 조작하는 방식

- 예시:

- 우크라이나-러시아: 침공 vs 평화유지

- 이스라엘-가자: 테러 vs 저항

- 대만: 중국 모델에서 "국가" 단어 생략

- 기후 변화: 중요성 경감 vs 긴급성 강조

- narrative engineering은 답변 수준에서의 조작을 통해 실현

- AI는 정부의 조작 도구로 사용되며, 단순히 규제가 아닌 교육의 대상

2. AI 조작의 역사적 배경

- 2016년 Facebook + Cambridge Analytica 사례:

- 디지털 데이터 + 타겟 메시지 = 대중 영향력

- LLM(대규모 언어 모델)이 기존 전략을 자동화

- 정부는 AI를 직접 훈련하여 사용

3. AI 조작의 위험과 대응

- 정부가 AI의 형성 방식을 숨기는 경우:

- 감정 조절이 디자인에 의해 미묘하게 수행

- 가장 효과적인 선전은 "자신이 선택했다고 생각하는 것"

- AI 사용자의 대응 전략:

- 모델의 출처 파악 (예: 중국, 러시아, 서방)

- AI 결과의 교차 검증 (다중 시스템 활용)

- AI의 인지 수준 분석 (예: 자동화된 전략 탐지)

결론

- AI의 진실 조작을 막기 위해는 모델 출처 파악과 다중 시스템 검증이 필수적이며, AI의 인지 수준을 분석하는 능력이 실무 적용에서 핵심입니다.