역전파와 경사 하강법 이해

카테고리

프로그래밍/소프트웨어 개발

서브카테고리

인공지능

대상자

- 대상: 딥러닝/머신러닝 모델 개발자, 알고리즘 설계자

- 난이도: 중급(미분, 체인 규칙, 최적화 알고리즘 기본 이해 필요)

핵심 요약

- 경사 하강법은 가중치와 편향을 업데이트하여 손실(Loss)을 최소화하는 학습 알고리즘

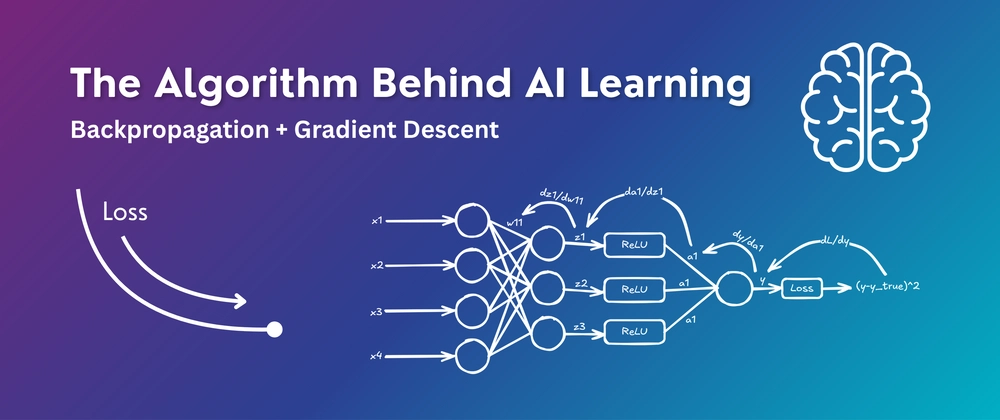

- 역전파(Backpropagation)는 체인 규칙을 적용하여 손실 함수의 기울기(Gradient)를 계산

- 손실 함수 예시: 평균 제곱 오차(MSE) → $ L = (y_{\text{pred}} - y_{\text{true}})^2 $

- 업데이트 공식: $ w = w - \eta \cdot \frac{\partial L}{\partial w} $, $ b = b - \eta \cdot \frac{\partial L}{\partial b} $

섹션별 세부 요약

1. 신경망의 학습 필수성

- 무작위 가중치로 학습하지 않으면 정확도가 낮음

- 손실 최소화와 정확도 최대화를 위해 가중치/편향 업데이트 필요

- 학습 과정: 에포크별 반복 → 손실이 최소화될 때까지 반복

2. 경사 하강법의 원리

- 손실 곡선의 최소점으로 이동 → 기울기와 학습률(learning rate) 기반

- 기울기 계산: $ \frac{\partial L}{\partial w} $, $ \frac{\partial L}{\partial b} $

- 학습률(η)은 업데이트 크기 조절 → 예: $ \eta = 0.05 $

3. 역전파의 역할

- 체인 규칙을 사용해 층별 기울기 계산

- 예: $ \frac{\partial L}{\partial w_{11}} = \frac{\partial L}{\partial y} \cdot \frac{\partial y}{\partial a_1} \cdot \frac{\partial a_1}{\partial z_1} \cdot \frac{\partial z_1}{\partial w_{11}} $

- 모든 가중치/편향에 대해 기울기 계산 → 역전파 명칭 유래

4. 경사 하강법의 적용

- 가중치/편향 업데이트: $ w = w - \eta \cdot \frac{\partial L}{\partial w} $

- 손실 감소 및 정확도 향상 → 에포크 반복으로 모델 최적화

결론

- 역전파 + 경사 하강법은 딥러닝 핵심 기술 → 모델 학습의 기반이 됨

- 학습률(η) 설정은 수렴 속도/정확도에 직접 영향 → 적절한 값 선택 필수

- 체인 규칙을 기반으로 한 역전파는 층간 기울기 계산의 핵심 알고리즘