Python으로부터 스크래치에서 LLM 웹 앱 만들기: Part 3 (FastAPI 및 WebSockets)

카테고리

프로그래밍/소프트웨어 개발

서브카테고리

웹 개발

대상자

- Python 웹 개발자, 실시간 애플리케이션 개발에 관심 있는 중급~고급 개발자

- FastAPI 및 WebSocket 기술의 실무 적용을 학습하고자 하는 개발자

핵심 요약

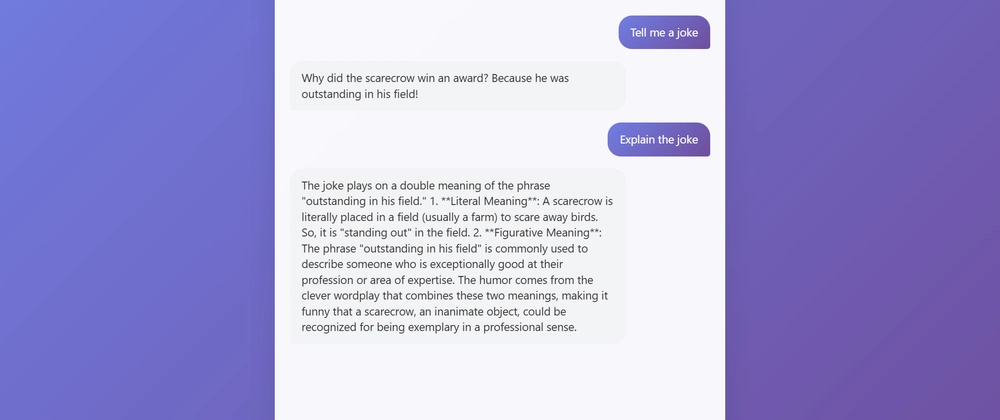

- WebSocket 기반 실시간 커뮤니케이션을 통해 사용자와 AI 모델 간 즉시 상호작용 가능

- FastAPI 프레임워크를 사용하여 고성능 웹 앱 구축 (Python 3.10+ 지원)

- 스트리밍 AI 기술로 로딩 스피너 대신 실시간 텍스트 흐름 제공 (예:

yield기반 반복자 사용)

섹션별 세부 요약

1. 스트리밍 AI의 중요성

- 전통적인 로딩 스피너 대신 실시간 텍스트 흐름으로 사용자 경험 향상

- AI 모델의 intermediate 결과 즉시 전달 가능 (예:

llm_streaming_response함수) - 사용자 참여도 증가 및 앱의 생동감 강화

2. FastAPI 기반 백엔드 구축

- Python 3.10+에서 동작하는 FastAPI 프레임워크 사용

- WebSocket 엔드포인트 정의:

@app.websocket("/ws")데코레이터 활용 - 비동기 처리를 위한

async def함수 구현 (예:async def stream_response(websocket: WebSocket))

3. WebSocket 통신 구현

- 클라이언트-서버 간 실시간 데이터 전송을 위한 WebSocket 프로토콜 사용

yield키워드를 통해 텍스트 흐름 생성 (예:for token in response_generator(): yield token)- 에러 처리 및 연결 종료 로직 포함 (예:

try-except블록 활용)

결론

- FastAPI와 WebSocket을 결합한 실시간 스트리밍 기능은 사용자 경험을 획기적으로 개선하며,

yield기반 반복자와 비동기 처리 패턴을 통해 구현 가능합니다.