아이들을 위한 이야기 생성을 위한 DeepSeek 모델 개발 및 훈련

카테고리

프로그래밍/소프트웨어 개발

서브카테고리

인공지능, 머신러닝, 바이브코딩

대상자

AI/머신러닝 개발자, 소프트웨어 엔지니어, 교육용 AI 도구 개발자

(난이도: 중급 이상, 모델 아키텍처 구현 및 훈련 파이프라인 이해 필요)

핵심 요약

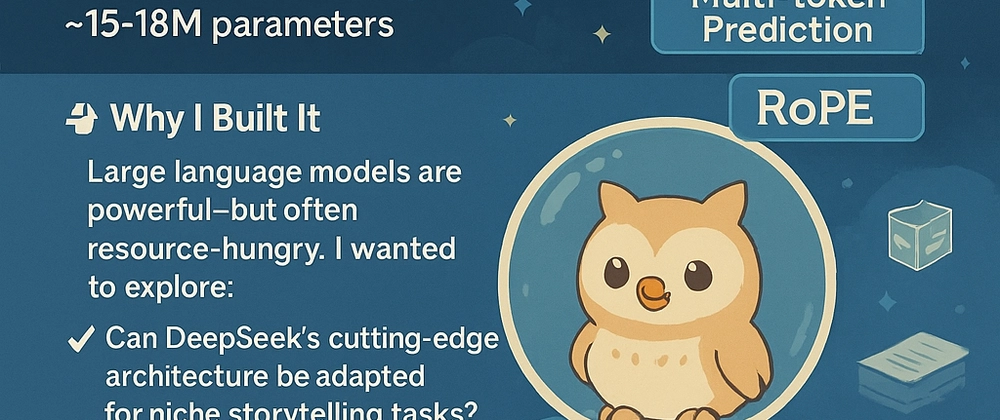

- DeepSeek-Children-Stories 모델: MLA + MoE + Multi-token prediction 아키텍처를 기반으로 15~18M 파라미터로 구성

- 훈련 파이프라인: Hugging Face의 2,000+ 어린이 이야기 데이터셋 사용, GPT-2 토크나이저 적용, PyTorch 2.0 컴파일로 최적화

- 핵심 목적: 작은 모델로도 고질량 콘텐츠 생성 가능 확인, 환경 영향 최소화 및 저비용 추론 구현

섹션별 세부 요약

1. 개발 목적

- 왜 대규모 언어 모델 대신 작은 모델로 접근했나?

- 대규모 모델의 자원 소모 문제 해결

- MLA/MoE 아키텍처를 활용한 스토리텔링 전용 모델 개발

- 목표: 작은 모델로도 창의적 콘텐츠 생성 가능 여부 검증

2. 핵심 아키텍처 구성 요소

- MLA (Multihead Latent Attention)

- 공유 키-값 헤드를 통한 효율적인 어텐션 메커니즘

- MoE (Mixture of Experts)

- 4개 전문가, Top-2 라우팅으로 성능 확장

- Multi-token Prediction

- 다음 2개 토큰 동시 예측으로 추론 속도 향상

- RoPE (Rotary Positional Encodings)

- 위치 정보를 더 정확하게 이해하는 정밀한 위치 인코딩

3. 훈련 파이프라인

- 데이터셋: Hugging Face 제공 2,000+ 고질량 어린이 이야기

- 토크나이저: GPT-2 토크나이저로 호환성 확보

- 훈련: 혼합 정밀도 + 그래디언트 스케일링 적용

- 최적화: PyTorch 2.0 컴파일로 훈련 속도 개선

4. 직접 구현 이유

- 사용자 맞춤형 아키텍처 구현: MLA/MoE 등 최신 기술 통합 가능

- 환경 영향 최소화: 작은 모델로 전력 소비 및 탄소 배출 감소

- 모델 내부 메커니즘 깊이 이해: 훈련/추론 과정의 전체 흐름 파악

결론

- 설치 명령어

setup.sh로 자동화된 훈련/배포 가능 - 훈련된 모델은 Hugging Face에서 바로 사용 가능 (🔗 https://huggingface.co/lakhera2023/deepseek-children-stories)

- 작은 모델도 고질량 콘텐츠 생성 가능을 증명한 사례로, 교육용 AI 개발자에게 유용한 참고 자료