Golang에서 신경망 개발

카테고리

프로그래밍/소프트웨어 개발

서브카테고리

인공지능, 머신러닝

대상자

- 머신러닝 알고리즘의 내부 메커니즘을 이해하고자 하는 개발자

- Go 언어의 수학적 연산 및 구조 설계를 학습하고자 하는 사람

- 높은 성능 요구사항의 저수준 라이브러리 구현에 관심 있는 개발자

핵심 요약

- Go의 표준 라이브러리만 사용해 Feedforward Neural Network 구현

- He 초기화법(ReLU 활성화) 및 일반 초기화(기타 활성화) 적용

- Forward/Backward 메서드에서 선형변환, 활성화, 가중치 업데이트 로직 구현

- Gorgonia, GoMind, GoLearn 등 외부 라이브러리의 활용 가능성 강조

섹션별 세부 요약

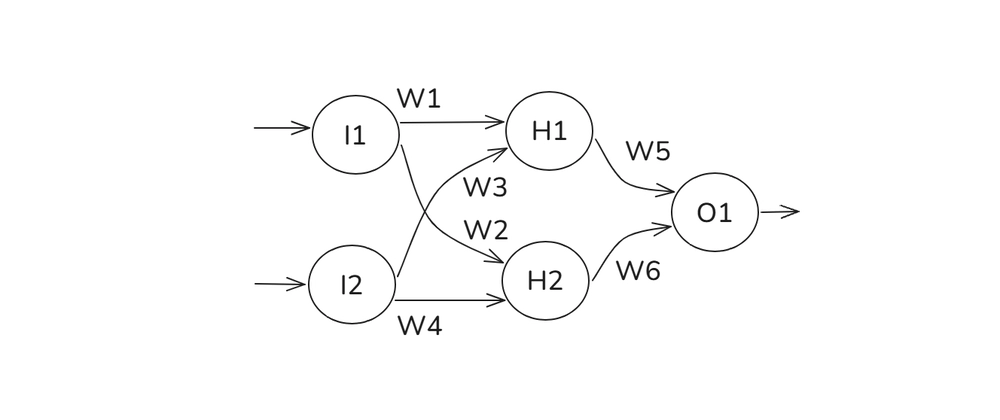

1. 신경망 구조 정의

NeuralNetworkLayer구조체에 가중치, 편향, 활성화 함수, 기울기 계산을 통합Weights(행렬),Biases(벡터),ActivationFunc(ReLU, Sigmoid) 등 핵심 필드 포함

2. 가중치 초기화 전략

- ReLU 활성화: He 초기화 (

math.Sqrt(2.0/inputSize)) 적용 - Sigmoid 등 다른 활성화: 표준 초기화 (

math.Sqrt(1.0/inputSize)) 적용 rand.NormFloat64()를 사용한 정규 분포 기반 무작위 초기화

3. 활성화 함수 구현

- ReLU:

max(0, x)로 비선형성 추가, vanishing gradient 방지 - Sigmoid:

1/(1+e^{-x})로 0~1 범위 확장, 분류 출력에 적합 SigmoidDerivative(x) = Sigmoid(x) * (1 - Sigmoid(x))ReLUDerivative(x) = 1.0 (x > 0) / 0.0 (x ≤ 0)

4. Forward/Backward 메서드

- Forward:

InputVector×Weights+Biases→WeightedSumsActivationFunc적용 →OutputVector

- Backward:

outputGradient×DerivativeFunc(WeightedSums)→activationGradientBiasGradients = activationGradientWeightGradients = OuterProduct(activationGradient, InputVector)InputGradient = TransposeMatrix(Weights) × activationGradient

5. 전체 신경망 구조

NeuralNetwork구조체:Layers배열로 여러NeuralNetworkLayer구성Predict(input []float64)메서드: 각 층의Forward메서드 연쇄 호출

결론

- Go로 신경망 구현 시 He 초기화(ReLU) 적용 권장

- Forward/Backward 메서드에서 행렬 연산과 기울기 계산이 핵심

- Gorgonia, GoMind 등 외부 라이브러리로 복잡한 모델 구현 가능

- 표준 라이브러리만 사용해도 핵심 알고리즘 이해 가능