구글, 새로운 '증강 미세조정' 제안..."ICL 일반화 강점에 미세조정 효율성 합쳐"

카테고리

데이터 과학/AI

서브카테고리

인공지능, 머신러닝

대상자

- *AI 연구자, 대규모 언어 모델(LLM) 개발자, 데이터 과학자**

- 난이도: 중간 이상 (기계 학습, ICL 개념 이해 필요)*

핵심 요약

- ICL(상황 내 학습)은 일반화 성능에서 미세조정(fine-tuning)보다 우수하지만 추론 계산 비용이 높음

- 구글은 ICL의 일반화 강점 + 미세조정의 효율성을 결합한 증강 미세조정(Augmented Fine-Tuning) 방식 제안

- 로컬/글로벌 전략으로 ICL 예제를 생성해 미세조정 데이터에 통합, 연산 비용 감소 및 모델 일반화 능력 향상

섹션별 세부 요약

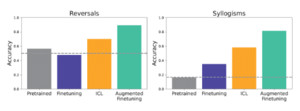

1. ICL vs. 미세조정 비교

- ICL: 모델 매개변수를 변경하지 않고, 프롬프트에 예제를 포함해 학습

- 미세조정: 소규모 데이터셋으로 모델 매개변수 재조정

- ICL은 사용자 접근성이 높지만, 추론 시 계산 비용 증가

2. 실험 설계 및 결과

- 통제된 인공 데이터셋 생성 (가상 가족관계, 허구 개념 등)

- 관계 역전, 삼단 논법 추론 등 복잡한 과제 평가

- Gemma 1.5 플래시 활용 결과: ICL이 논리적 추론 과제에서 일반화 성능 우수

3. 증강 미세조정(Augmented Fine-Tuning)

- ICL 능력 활용해 새로운 예제 생성 → 미세조정 데이터에 통합

- 로컬 전략: 개별 문장 변형, 역추론

- 글로벌 전략: 전체 데이터셋을 문맥으로 제공 → 깊은 추론 유도

- 연산 비용 감소 (반복 사용 시 ICL 대비 저렴)

4. 연구자 의견 및 전망

- 맷 람피넨: "데이터 증강 비용은 있지만, 모델 반복 사용 시 전체 비용 절감"

- 미세조정만으로 성능 부족 시 증강 미세조정 권장

결론

- 증강 미세조정은 ICL의 일반화 강점과 미세조정의 효율성을 결합한 실용적 접근법

- 로컬/글로벌 전략 활용해 예제 생성 → 모델 일반화 능력 향상 및 연산 비용 절감

- AI 모델 개발자는 ICL만으로 성능 부족 시 증강 미세조정 적용 권장