대규모 언어 모델(LLM)의 규모와 정량화의 역할

카테고리

프로그래밍/소프트웨어 개발

서브카테고리

인공지능

대상자

AI/머신러닝 개발자, 모델 최적화에 관심 있는 연구자 및 엔지니어

(난이도: 중급 - 정량화, IEEE 754, 정밀도 관련 개념 이해 필요)

핵심 요약

- LLM은 수십억 개의 floating-point 파라미터로 구성되어 있으며, 이는 인간 언어의 복잡성을 표현하기 위해 필수적이다.

- 정밀도(예: 16비트, 32비트)는 메모리 사용량과 계산 오차를 직접적으로 결정하며, 32비트가 고정밀 분야에서 선호된다.

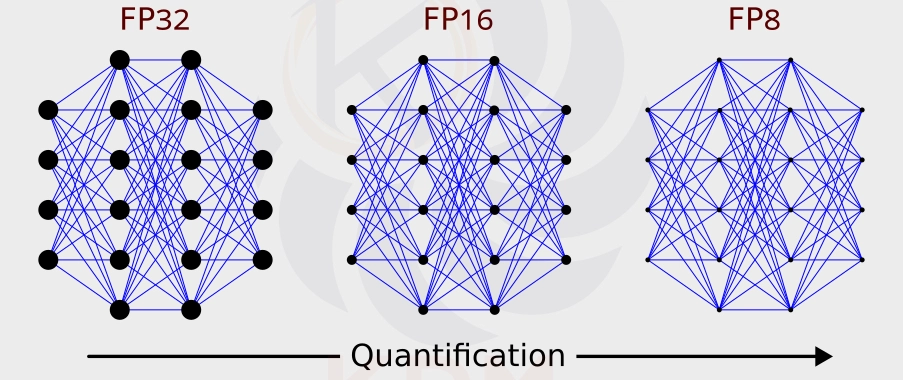

- 정량화(Quantization)는 파라미터의 정밀도를 낮추어 모델 크기를 줄이는 동시에 성능을 유지하는 핵심 기술이다.

섹션별 세부 요약

1. LLM의 파라미터 구조 및 규모

- LLM은 수십억 개의 floating-point 파라미터(예: LLaMA 3.2 1B, GPT-4)로 구성되어 있으며, 이는 언어 패턴 학습을 위해 필요하다.

- 파라미터는 초기 무작위 값에서 학습 과정을 통해 최적화되며, 계산 오차를 줄이는 것이 중요하다.

- 정밀도가 높을수록 메모리 사용량 증가, 예: 32비트는 4바이트, 16비트는 2바이트 소요.

2. IEEE 754와 floating-point 표현

- IEEE 754는 floating-point 수를 16비트, 32비트, 64비트로 표현하며, 정확한 계산을 위해 설계되었다.

- 예: π의 32비트 표현은 3.1415927410125732, 16비트는 3.140625로 오차 발생.

- 0.1과 같은 유리수도 16비트에서는 0.0999755859375로 표현되며, 32비트에서는 더 정확하게 표현 가능.

3. floating-point의 한계 및 LLM에의 적용

- floating-point는 무한소수(예: π)를 정확히 표현할 수 없으며, 이는 오차가 누적될 수 있는 위험을 초래한다.

- LLM은 정수 대신 floating-point를 사용하는 이유: 정밀도가 높은 범위의 수치(예: 신경망의 활성화 값)를 표현하기 위해.

- GPU/NPU는 floating-point 연산에 최적화되어 있어, LLM의 성능 향상에 기여.

4. 정량화(Quantization)의 필요성

- 정량화는 32비트 파라미터를 16비트로 축소하여 메모리 사용량을 50% 절감할 수 있다.

- mixed-precision training은 고정밀 파라미터(32비트)와 저정밀 파라미터(16비트)를 혼합해 성능과 효율 균형을 맞춘다.

- 정량화는 모델의 압축과 추론 속도 향상에 기여하며, 모바일/엣지 기기에서 유리.

결론

- LLM의 규모는 floating-point 파라미터의 정밀도와 연관되며, 정량화를 통해 메모리 사용량을 줄이고 성능을 유지할 수 있다.

- 실무 적용 시 mixed-precision training과 16비트/32비트 파라미터 혼합을 고려하고, IEEE 754의 정밀도 영향을 분석해야 한다.

- 정량화는 모델 압축과 추론 효율성 향상에 필수적이며, AI 엔지니어링의 핵심 기술로 자리 잡고 있다.