LM Studio와 Qwen3로 시작하는 로컬 AI 개발 환경 구축

카테고리

프로그래밍/소프트웨어 개발

서브카테고리

개발 툴

대상자

AI 개발자, 로컬 환경에서 LLM 실행을 원하는 프로그래머

난이도: 중급(기본 CLI 사용 경험 필요)

핵심 요약

- Qwen3는 Mixture-of-Experts(MoE) 아키텍처를 채택한 2025년 4월 출시된 3세대 LLM으로, Apache 2.0 라이선스 적용

- LM Studio를 통해 로컬에서 Qwen3 모델 실행 가능, API 서버 및 CLI 지원

- Qwen3-4B는 Qwen2.5-7B 성능 수준 달성, 작은 모델의 효율성 강조

섹션별 세부 요약

- Qwen3 모델 개요

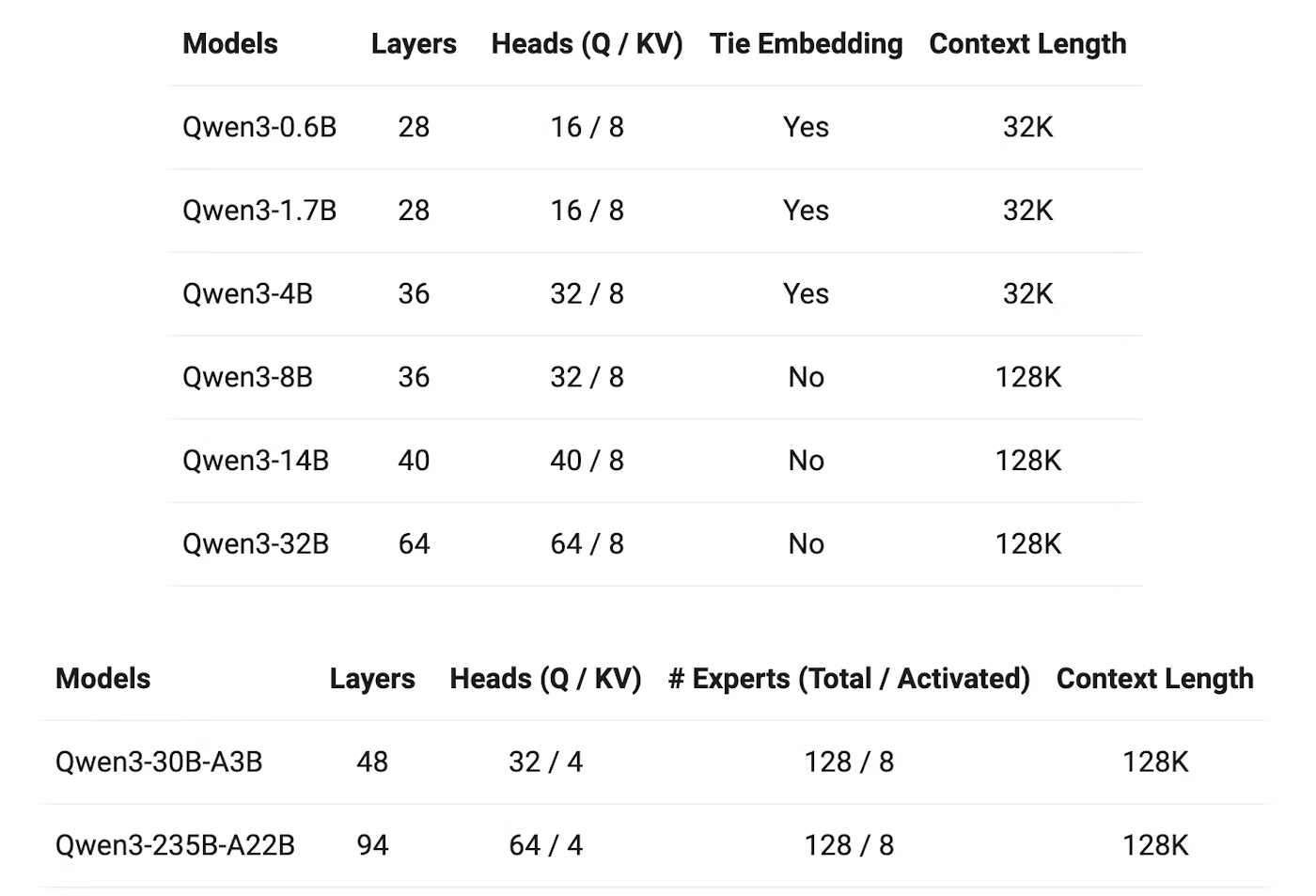

- MoE 모델: Qwen3-30B-A3B(22B 활성 파라미터), Qwen3-235B-A22B

- 밀집 모델: Qwen3-32B, Qwen3-1.7B(0.6B~32B 파라미터 범위)

- 모델 성능: Qwen3-4B ≈ Qwen2.5-7B, Qwen3-32B ≈ Qwen2.5-72B

- Qwen3의 핵심 기능

- 사고 모드 전환: 복잡한 문제 해결 시 단계적 추론 지원

- 다국어 지원: 119개 언어 포함(한국어 지원)

- 4단계 트레이닝 파이프라인으로 사고 능력 강화

- LM Studio 설치 및 사용

- CLI 설치 명령어:

- macOS/Linux: ~/.lmstudio/bin/lms bootstrap

- Windows: cmd /c %USERPROFILE%/.lmstudio/bin/lms.exe bootstrap

- 모델 실행 예시:

lms get qwen3-1.7b명령어로 인터랙티브 세션 시작

- API 활용 방법

- Python 예제:

```python

from openai import OpenAI

client = OpenAI(base_url="...", api_key="lm-studio")

completion = client.chat.completions.create(model="qwen3-1.7b", ...)

```

- Apidog 사용: 스트리밍 응답 테스트 시

"stream": true파라미터 추가

- 성능 및 활용 팁

- Qwen3-4B는 일반 PC에서도 원활한 실행 가능

- 하이브리드 사고 모드 및 다국어 지원이 실제 프로젝트에 유리

결론

- *Qwen3-4B 모델을 선택해 로컬 환경에서 고성능 LLM 실행하고, LM Studio CLI와 Apidog을 활용해 API 테스트와 디버깅을 효율화하세요. 로컬 개발 시 프라이버시 보장과 비용 절감**의 이점을 누릴 수 있습니다.