모델 컨텍스트 프로토콜(MCP)을 활용한 LLM과 AI 에이전트 통합

카테고리

프로그래밍/소프트웨어 개발

서브카테고리

인공지능, 머신러닝

대상자

LLM(대규모 언어 모델)과 AI 에이전트를 개발하거나 통합하는 개발자, 특히 Python 및 TypeScript 기반의 프로젝트를 진행하는 개발자

핵심 요약

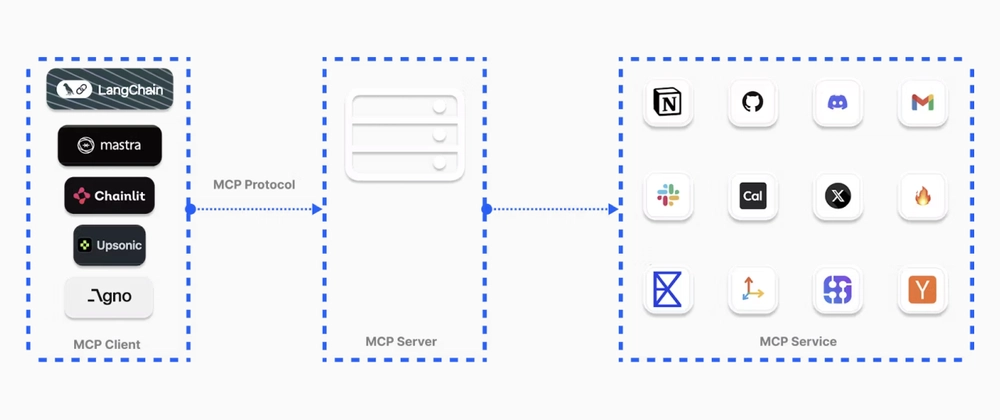

- MCP는 LLM과 AI 에이전트가 외부 도구, 실시간 데이터, API 등을 활용해 사용자 요청에 대한 정확한 답변을 제공할 수 있도록 문맥 정보를 제공하는 오픈소스 프로토콜

- MCP의 주요 장점은 도구 관리의 용이성, 확장성, 보안 기능(인증 및 권한 시스템)을 포함

- MCP 서버 유형은 Server-Sent Events(SSE)와 STDIO로, 각각 HTTP 기반 원격 서비스 및 로컬 명령 실행을 지원

섹션별 세부 요약

1. MCP의 필요성

- LLM과 AI 에이전트는 기본적으로 외부 도구 또는 실시간 정보에 접근하지 못함

- MCP를 통해 도구 통합, 외부 API 호출, 웹 브라우징 등이 가능해짐

- Composio와 Agents.json은 MCP와 유사하지만, MCP가 더 널리 채택되고 표준화됨

2. MCP의 작동 원리

- 사용자가 요청을 보냄 → 에이전트가 MCP 서버와 도구를 연결하여 필요한 정보를 수집 → 사용자에게 응답

- 예: ChatGPT가 특정 Slack 채널 메시지 전송, 일정 확인 등 외부 애플리케이션 사용 가능

3. MCP의 주요 이점

- 도구 관리 용이성: 100개 이상의 도구를 MCP 레지스트리에서 중앙화된 방식으로 접근 가능

- 보안 강화: 인증 시스템을 통해 Google Sheets, Gmail 등과의 인증 가능

- 확장성: 수천 개의 MCP 서버를 지원하는 OpenTools, Smithery 등 레지스트리 활용 가능

4. MCP 서버 유형 및 레지스트리

- SSE: HTTP 기반 원격 서버 연결

- STDIO: 로컬 명령 실행 및 표준 입출력을 통한 커뮤니케이션

- 레지스트리 예시:

- OpenTools: Python, TypeScript, Curl 지원

- Smithery: 2000개 이상의 MCP 서버 제공

- Glama Registry: 생산성 향상용 오픈소스 서버

5. MCP 구현 예시

from openai import OpenAI

client = OpenAI(

base_url="...",

api_key=""

)

completion = client.chat.completions.create(

model="anthropic/claude-3.7-sonnet",

messages=[{"role": "user", "content": "Compare specs of top 5 EVs on caranddriver.com"}],

tools=[{"type": "mcp", "ref": "firecrawl"}]

) - OpenTools API를 활용해 웹 검색, 실시간 위치 데이터, 웹 크롤링 등 가능

결론

MCP는 LLM과 AI 에이전트가 외부 도구를 효과적으로 활용할 수 있도록 표준화된 프로토콜로, OpenTools, Smithery 등 레지스트리를 통해 다양한 도구를 확장 가능. 구현 시 SSE/STDIO 서버 유형을 선택하고, OpenAI의 Agents SDK와 같은 프레임워크를 활용하는 것이 권장됨.