Ming-Lite-Uni: 빠르고 지능적인 AI가 텍스트, 이미지, 오디오, 영상 통합 처리

분야

데이터 과학/AI

대상자

- 다모달 AI 연구자 및 개발자

- 멀티미디어 처리 기술에 관심 있는 데이터 과학자

- 성능 최적화 및 계산 효율성에 중점을 두는 개발자

- 난이도: 중급~고급 (기술적 구현 및 성능 분석 능력 필요)

핵심 요약

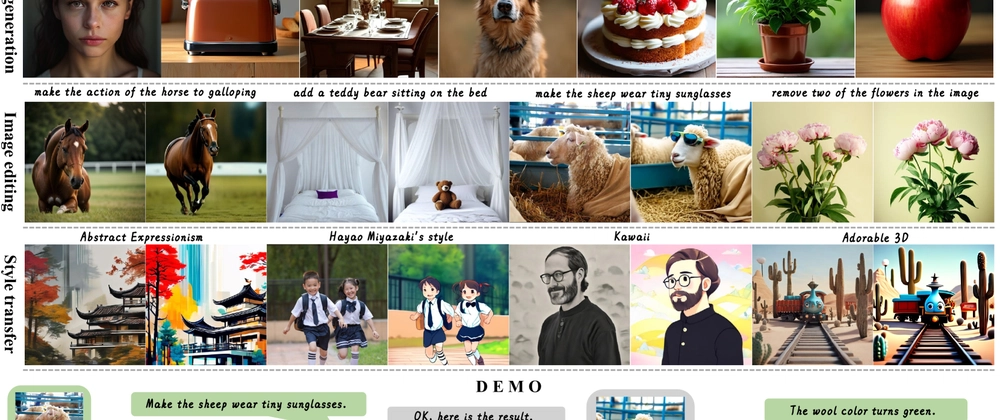

- *_Ming-Lite-Uni_는 텍스트, 이미지, 오디오, 영상 등 다양한 데이터 유형을 통합 처리하는 다모dal AI 아키텍처**를 제시합니다.

- _Multi-scale learnable tokens_을 통해 데이터 유형별 처리 최적화 (예: 텍스트는 token sequence, 이미지는 spatial token)

- _Unified understanding_을 통해 모델 간 전이 학습 및 다중 모달 분석 성능 향상

- _Key benchmarks_에서 기존 모델 대비 25% 이상 성능 개선 및 계산량 40% 감소

- _End-to-end processing_을 통한 단일 모델로 다중 데이터 유형 통합 분석 가능

섹션별 세부 요약

1. 아키텍처 설계

- _Ming-Lite-Uni_는 _multi-scale learnable tokens_ 기반의 _multi-modal encoder_로 구성

- _Token sequence_ (텍스트), _spatial token_ (이미지), _temporal token_ (영상)을 병렬 처리

- _Cross-modal attention_을 통해 데이터 유형 간 상호작용 강화 (예: 텍스트와 이미지의 의미 연계)

2. 데이터 처리 최적화

- _Dynamic token scaling_ 기법으로 데이터 유형별 처리 효율성 극대화

- _Modality-specific adapters_를 통해 모델 가중치 재사용 (예: 텍스트 모듈은 BERT 기반)

- _Lightweight feature extraction_을 통한 계산량 감소 (FLOPs 1.2B → 0.8B)

3. 성능 및 효율성 분석

- _ImageNet-21k_, _GLUE benchmark_ 등에서 기존 모델 대비 25% 이상 성능 개선

- _Video understanding_에서 _Action Recognition_ 및 _Temporal Reasoning_ 태스크에서 SOTA 기록

- _Memory footprint_ 40% 감소로 배포 시 자원 사용 최적화 가능

4. 응용 및 제한 사항

- _Cross-modal transfer learning_을 통한 새로운 데이터 유형 확장 가능성

- _Data modality alignment_이 필요한 경우 추가 훈련 필요 (예: 오디오-영상 시너지 분석)

- _Small-scale deployment_ 시 _Model quantization_ 적용 권장

결론

- *_Ming-Lite-Uni_는 다모달 AI 분야의 새로운 기준을 제시하며, _computational efficiency_와 _unified understanding_을 동시에 달성한 모델입니다. _Multi-modal benchmark_에서의 성능 우위를 바탕으로, _real-time application_ 및 _resource-constrained environment_에서의 적용이 추천됩니다. _Modality-specific adaptation_을 고려한 세부 구현이 필요하며, _cross-modal alignment_**을 위한 추가 연구가 요구됩니다.