Ollama Dev Stack: 로컬 AI 환경 구축 프레임워크

카테고리

프로그래밍/소프트웨어 개발

서브카테고리

인공지능

대상자

AI/머신러닝 개발자, DevOps 엔지니어, 시스템 관리자

난이도: 중간 (Docker, CLI 명령어, 스크립트 작성 기초 지식 요구)

핵심 요약

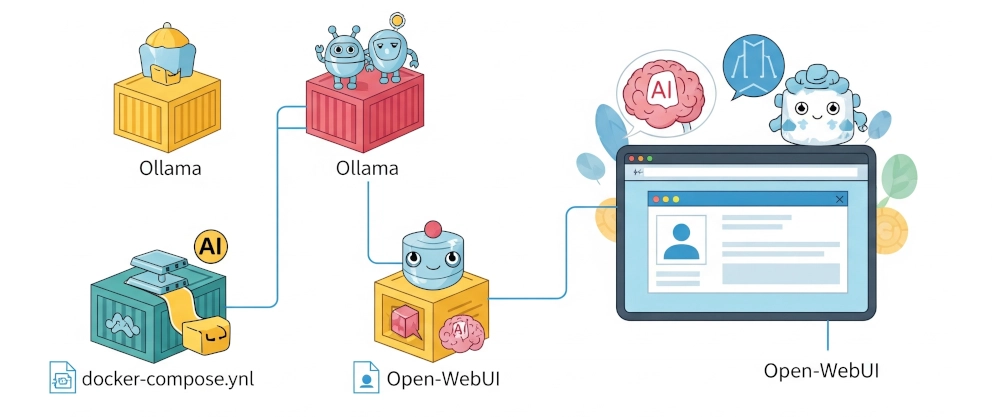

- Docker 기반의 로컬 AI 환경 구축 프레임워크 제공 (

mori-ollama-srv프로젝트) - 자동화된 벤치마크와 컨테이너 실패 대응 기능 포함

- DeepSeek Coder, Mistral, Llama 등 주요 LLM 모델 지원

섹션별 세부 요약

1. 개요

- 로컬 AI 환경 구축을 위한 5가지 핵심 기능 제시

make dev또는setup-dev.sh명령어로 빠르게 시작 가능- 컨테이너 실패 시 자동 재시작 기능 포함

2. 주요 기능

- Open-WebUI 인터페이스 제공 (대화형 채팅 지원)

- Docker Compose + Makefile을 통한 구축 단순화

- CPU 성능 최적화 모드 활성화 (Linux 지원)

- 로컬/원격 서버에서 실행 가능 (SSH 기반)

3. 설정 명령어

make install ARGS="--light": 가벼운 설치 옵션make install ARGS="--no-benchmark": 벤치마크 생략make install ARGS="--remote=me@192.168.100.10": 원격 서버 설치

4. UI 접근

- 설정 완료 후

http://localhost:3000에서 대시보드 접근 가능 - GitHub: https://github.com/rafa-mori/mori-ollama-srv

- Gist: https://gist.github.com/faelmori/463092315840a09417268b13f8fee1a8

결론

- Docker 기반의 모듈화된 구조와 자동화 스크립트를 통해 빠른 로컬 AI 환경 구축 가능

- MIT 라이선스 적용 및 커뮤니티 기여 유도

- DeepSeek Coder, Mistral 등 주요 모델 지원으로 실험 및 개발 효율성 향상