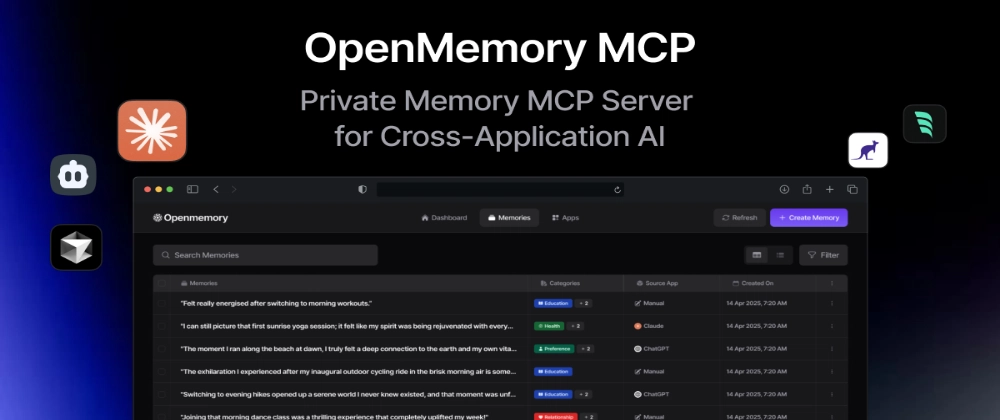

OpenMemory MCP로 클라이언트의 컨텍스트 인지 능력 향상 방법

카테고리

프로그래밍/소프트웨어 개발

서브카테고리

인공지능

대상자

- AI 개발자 및 시스템 엔지니어

- Docker, Qdrant, Mem0 기반의 로컬 메모리 시스템 구축에 관심 있는 중급~고급 개발자

- LLM 클라이언트(예: Cursor, Claude Desktop)의 컨텍스트 인지 기능 확장 필요성 있는 사용자

핵심 요약

- OpenMemory MCP는

Docker + Postgres + Qdrant기반의 로컬 메모리 레이어로, LLM 클라이언트 간 세션 간 메모리 지속성 제공 - Qdrant 벡터 저장소를 활용한 의미 기반 검색과 ACL 기반의 권한 관리를 통한 보안 강화

docker-compose명령어로 서버 구동,add_memories()/search_memory()등 MCP 프로토콜 메서드 지원

섹션별 세부 요약

1. OpenMemory MCP 개요 및 중요성

- LLM의 세션 간 메모리 유실 문제 해결을 위한 로컬 저장소 기반 메모리 레이어

- MCP 프로토콜 호환 클라이언트(Cursor, Claude Desktop 등)에 컨텍스트 인지 기능 제공

- Qdrant를 통한 벡터 기반 검색으로 단순 키워드 매칭보다 의미 유사도 기반 검색 가능

2. 시스템 구성 및 핵심 흐름

docker-compose명령어로 API, Qdrant, Postgres 컨테이너 구성- MCP 서버(Mem0 기반)가 SSE(Simple Server-Sent Events)를 통해

/mcp/...엔드포인트로 클라이언트와 통신 - 클라이언트에서

add_memories(),search_memory()등 메서드 호출 시 Qdrant 벡터 인덱싱 및 내부 로그 관리 처리

3. 설치 및 설정 가이드

- 필수 조건: Docker, Python 3.9+, Node.js, OpenAI API Key, GNU Make

- 설치 명령어:

```bash

git clone https://github.com/mem0ai/mem0.git

cd openmemory

export OPENAI_API_KEY=your_api_key_here

make env

make build

make up

```

- 프론트엔드 실행:

make ui명령어로 Next.js 기반 대시보드 구동

4. 대시보드 기능 및 사용 사례

- 대시보드 주요 라우트:

- /: 메모리/앱 통계, 설치 명령어 제공

- /memories: 저장된 메모리 관리 및 필터링

- /apps: 연결된 앱 상태 확인

- 필터링 기능: 앱/카테고리 선택, 아카이브 항목 표시, 정렬 기준 설정

- 메모리 관리: 개별 메모리 아카이브/삭제/복구 및 접근 로그 확인 가능

5. 기술적 구성 요소 및 API

- 프론트엔드 핵심 컴포넌트:

- MemoryFilters.tsx: 검색 입력, 필터 대화상자, 대량 작업 관리

- MemoriesSection.tsx: 메모리 목록 로딩 및 페이징 처리

- MemoryTable.tsx: 메모리 ID, 내용, 태그, 생성일 등 표시

- 상태 관리:

- useStats.ts: 총 메모리/앱 수 통계 로드

- useMemoriesApi.ts: 메모리 조회/삭제/업데이트 API 처리

결론

- OpenMemory MCP는 Docker 기반의 로컬 메모리 레이어로, LLM 클라이언트의 컨텍스트 인지 기능을 향상시키는 데 유용

docker-compose로 간단히 설치 가능하며, Qdrant 벡터 저장소를 통한 의미 기반 검색 및 ACL 기반 보안 제공- 대시보드를 통해 메모리 관리, 앱 상태 확인, 실시간 로그 모니터링 가능하며, MCP 프로토콜 호환 클라이언트와의 연동이 용이