자체 AI 어시스턴트 생성: Jan과 Pinggy를 활용한 프라이빗 솔루션

카테고리

프로그래밍/소프트웨어 개발

서브카테고리

인공지능

대상자

- 개발자 및 IT 전문가에게 유용 (개인/기업의 데이터 보안과 제어권 확보 요구)

- 난이도: 초보자도 이해 가능한 단계별 가이드 제공 (30분 내 구현 가능)

핵심 요약

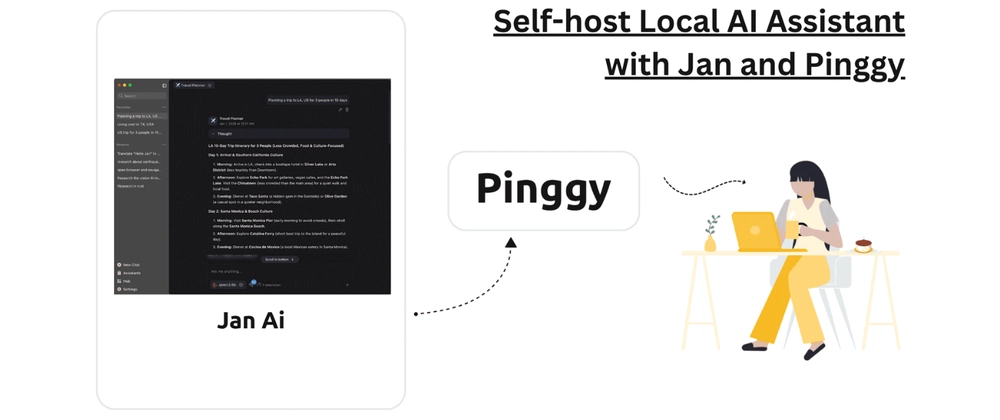

- 자체 AI 어시스턴트 구축 가능: Jan (로컬 실행, 오픈소스) + Pinggy (인터넷 공유) 활용

- 로컬 모델 사용 시 프라이버시 보장 및 클라우드 의존성 제거

- OpenAI 호환 REST API 지원 (스키마:

curl --location 'http://localhost:1337/v1/chat/completions')

섹션별 세부 요약

1. 기존 AI 어시스턴트의 한계

- 클라우드 의존성으로 인한 토큰 제한, 구독료, 데이터 수집 우려

- Jan은 로컬 실행 (브라우저/클라우드 없이 작동)

- Pinggy를 통해 DNS/포트 설정 없이 인터넷 공유 가능

2. Jan 설치 및 모델 설정

- GGUF 포맷의 로컬 모델 지원 (예:

qwen2.5,phi3.5) - Hub 탭에서 모델 다운로드 및 선택 (RAM 8GB 이상 추천)

- Pro Tip: 작은 모델부터 테스트 후 확장

3. 클라우드 LLM 연동 (Hybrid 모드)

- OpenAI, Claude, Google Gemini 등 외부 제공자 연동 가능

- 설정 → Model Providers에서 API 키 입력 후 전환

4. API 서버 설정

- OpenAI 호환 REST API 활성화:

Settings → Local API Server에서 API 키 설정- curl 명령 예시:

```bash

curl --location 'http://localhost:1337/v1/chat/completions'

--header 'Content-Type: application/json'

--header 'Authorization: Bearer dev-api-key'

```

5. Pinggy를 통한 공유 및 보안

- SSH 터널링으로 로컬 Jan 인스턴스 공유:

```bash

ssh -p 443 -R0:localhost:1337 -t qr@a.pinggy.io "u:Host:localhost:1337"

```

- 기본 인증 추가:

a.pinggy.io b:username:password - Pinggy Pro로 커스텀 도메인 매핑 가능 (예:

ai.yourcompany.dev)

결론

- 로컬 AI 모델 + Pinggy로 프라이버시 보장 및 클라우드 연동 유연성 확보

- Jan의 OpenAI 호환 API는 내부 시스템 통합 시 성능 향상에 유리

- 개발자/IT 전문가에게 자체 AI 솔루션 구축을 간소화하는 핵심 툴 제공