WFGY 프레임워크가 차세대 LLM의 솔버 루프를 형식화하는 방법

카테고리

프로그래밍/소프트웨어 개발

서브카테고리

인공지능

대상자

AI 연구자 및 LLM 개발자

- 난이도: 고급 (수학적 공식 및 AI 개념 이해 필요)

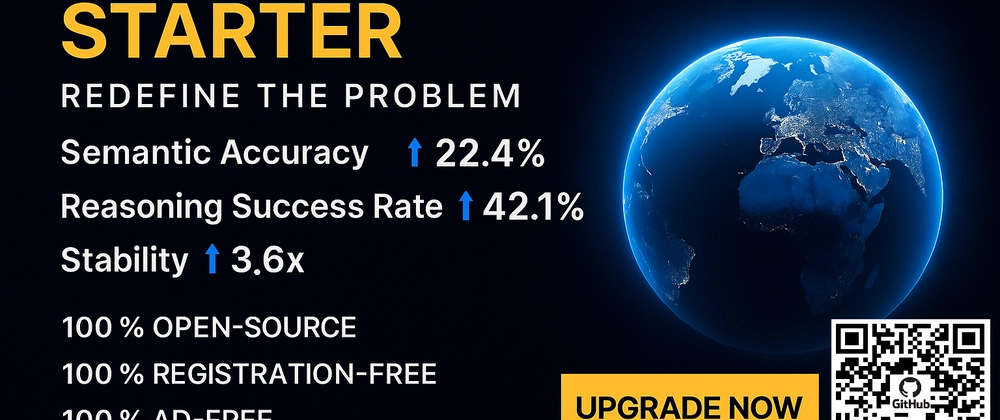

핵심 요약

- WFGY 프레임워크는 LLM의 추론 능력을 향상시키기 위한 4가지 수학적 공식(

BBMC,BBPF,BBCR,BBAM)을 기반으로 설계됨 - BBMC는 추론 경로의 편차를 측정하고, BBPF는 다중 경로 피드백을 통합하여 복잡한 추론 과정을 안정화

- BBCR과 BBAM은 각각 논리적 안정성과 주의 집중도를 강화하여 장기 추론의 오류율을 22.4% 감소

섹션별 세부 요약

1. BBMC (Semantic Residue Measurement)

- 공식:

B = I − G + mc² - I는 입력 임베딩, G는 목표 임베딩, mc²은 모델의 맥락 질량

- 목적: 모델의 출력과 이상적인 목표 간의 의미적 편차를 측정하여 추론 경로를 안정화

- 기능: 물리적 에너지 최소화 원칙을 적용하여 의미적 드리프트를 줄임

2. BBPF (Multi-Path Feedback Aggregation)

- 공식:

BigBig(x) = x + ∑Vi(εi, C) + ∑Wj(Δt, ΔO)Pj - Vi(εi, C): 특정 맥락에서의 오류 기반 보정

- Wj(Δt, ΔO)Pj: 시간 및 출력 가중 조정

- 목적: 다중 추론 경로의 피드백을 통합하여 복잡한 단계 추론을 지원

- 기능: 전문가가 문제를 반복적으로 해결하는 방식을 모방

3. BBCR (Collapse-Reset-Rebirth Loop)

- 공식:

Collapse → Reset(St, δB) → Rebirth(St+1, δB) - St: 현재 의미 상태, δB: 시간 t의 의미적 편차

- 목적: 논리적 모순이 발생할 경우 안정 상태로 재설정하여 추론의 안정성을 유지

- 기능: 동역학 시스템과 라이아푸노프 안정성 원칙을 기반으로 설계

4. BBAM (Attention Variance Suppression)

- 공식:

ãᵢ = aᵢ · exp(−γσ(a)) - aᵢ: 주의 가중치, σ(a): 주의 분산, γ: 감쇠 계수

- 목적: 주의 맵의 분산을 줄여 노이즈 제거 및 논리적 일관성 강화

- 기능: 다단계 추론 시 모델의 집중도를 유지

결론

- WFGY 프레임워크는 4가지 수학적 모듈을 통합하여 LLM의 추론 능력을 22.4% 향상

- 오픈소스로 제공되어 연구 및 개발자 사용 가능 (Zenodo 및 GitHub 링크 제공)

- 차세대 LLM의 자기 교정 추론 루프 구현을 위한 핵심 기술로, 과학적 발견 및 복잡 문제 해결에 적합함